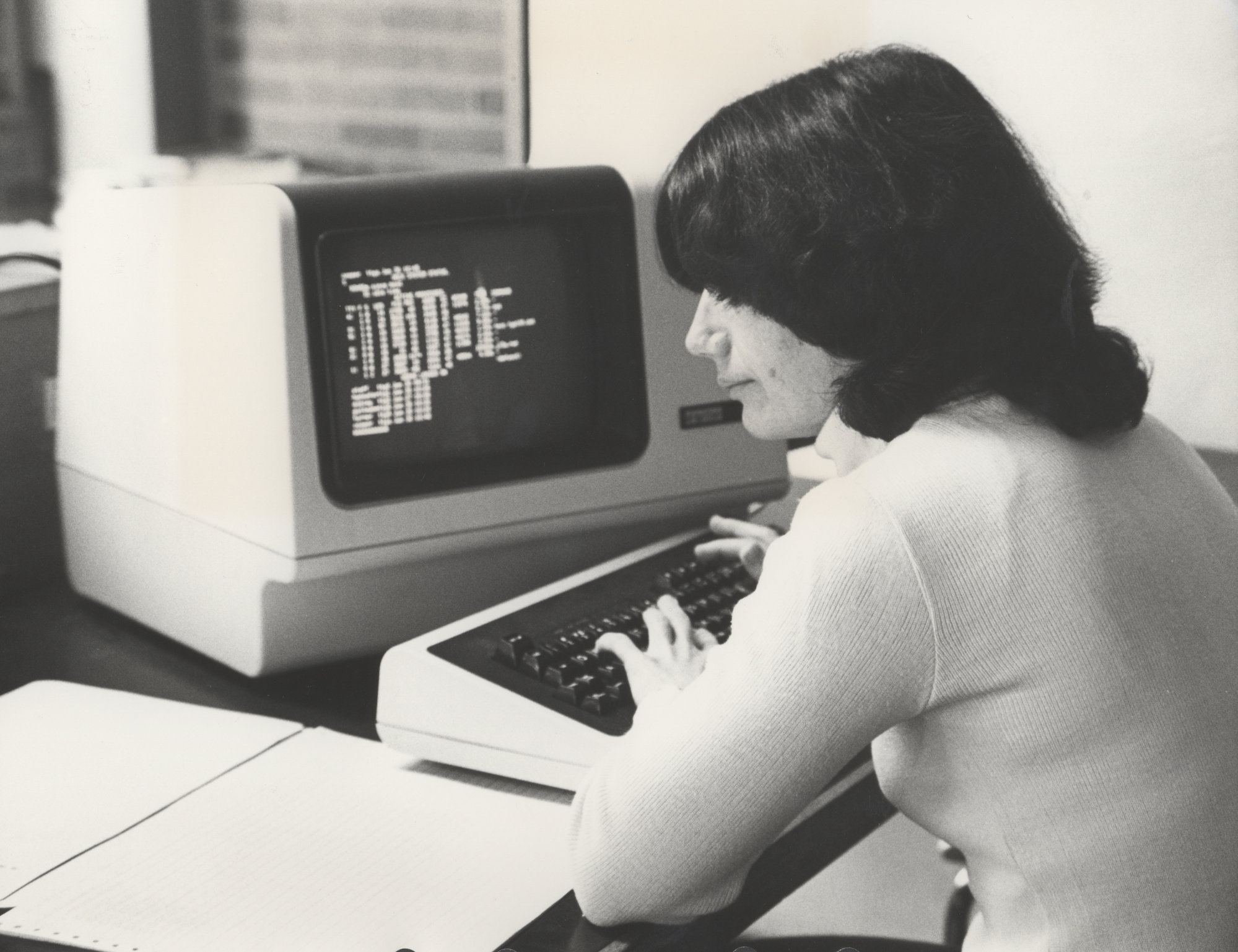

Llevamos más de medio siglo mirando pantallas. Y gracias al cielo que aparecieron, porque lo de las tarjetas perforadas era too much. Los monitores —junto a los ratones y teclados—se convirtieron rápidamente en la mejor forma de interactuar con las máquinas. Eran su forma de «hablarnos», y ha seguido siéndolo con cada nuevo cacharrito que ha aparecido en nuestras.

Por supuesto, el móvil ha sido el máximo exponente del protagonismo de las pantallas. En el móvil el ratón y el teclado convencionales han sido reemplazados por teclados virtuales y el tacto, pero la pantalla sigue estando ahí, perenne, porque no había alternativa mejor.

Pero ahora puede que la haya. Y esa alternativa es la voz.

Es algo de lo que llevo mucho (mucho) tiempo hablando pero que siempre estaba ahí, acechando. Y ahora parece que el momento está casi encima de nosotros. Lo estamos viviendo con la revolución de la IA, que nos ha dado en mi opinión dos grandes vistazos al futuro de nuestra interacción con nuestros dispositivos.

- GPT-4o. Con este modelo de IA vimos realmente cómo podía ser la interacción con un móvil con una conversación natural de voz como absoluta protagonista.

- Project Astra. Google ya lo había presentado, pero esta semana en la espectacular charla de Google I/O vimos de nuevo esa interacción con el vídeo del chaval que arreglaba su bici.

Todo apunta a lo mismo: a un futuro tipo ‘Her’ —ese que yo dije que esperaba que nunca llegara—en el que todos dejaremos de mirar pantallas todo el tiempo. Estas pasarán a un segundo plano y lo esencial será hablar con nuestros dispositivos.

Y en esas están precisamente todos los que están moviéndose en el terreno del hardware IA. Ante el glorioso desastre del Humane AI Pin, ahora todo apunta a una verdadera explosión de ñafotas, pero también de otros dispositivos.

Y precisamente entre ellos estará el que plantean Jony Ive y Sam Altman, que esta semana anunciaban que unen fuerzas para desarrollar ese futuro dispositivo de hardware IA. El vídeo, por si no lo habéis visto —no dejan embeberlo—, es rarito. Es casi como si estuviera hecho con IA —y si es así, muy bien hecho—, pero lo esté o no, sigue siendo rarito. Me pareció especialmente graciosa esta parodia sobre Jony Ive, sobre todo porque es súper acertada. Y no es, pero es como si lo fuera.

Esa capacidad de Altman y Ive para hablar en plan inspirador y vendemotos es patente en ese vídeo, porque lo poco que dicen de ese futuro dispositivo es que «el mejor trabajo que nuestro equipo ha hecho jamás». Altman, que ha «podido vivir con él» cree que es «el pedazo de tecnología más alucinante que el mundo jamás habrá visto».

Según The Wall Street Journal, Altman y Ive piensan distribuir (ship =!vender) 100 millones de ellos «más rápido que ninguna otra compañía haya vendido 100 millones de algo nunca antes», y hablaron de algunas cosas que rodearían al ese futuro producto:

- Será capaz de percibir los alrededores del usuario: o sea, que tendrá micrófonos y lo escuchará todo

- Será no obstrusivo y podremos meterlo en el bolsillo o ponerlo de la mesa: así que será relativamente pequeño, como mucho del tamaño de un smartphone, pero probablemente más pequeño

- Será el tercer dispositivo clave que pondremos en una mesa junto al iPhone y al MacBook Pro: así que será un complemento del móvil, no su sustituto.

En WSJ dejaron claro que no será ni un móvil ni unas gafas —eso lo confirmó Altman— pero sobre todo hay otra cosa importante. Según el diario, no tendrá pantalla. Es algo con lo que coincide MG Siegler, que hablaba de un «Anti iPhone» aunque creo que más bien será un «co-iPhone», el complemento definitivo, al menos durante un tiempo. ¿Por qué? Pues porque las pantallas seguirán siendo importantes para muchas cosas, incluidos las imágenes y los vídeos cortos que ahora nos tienen pegados a esas pantallas.

Para Siegler el dispositivo será una especie de grabadora, y eso también tiene sentido. El producto no solo será la nueva forma de usar la IA con la voz, sino que también será esa forma de recolectar todo lo que hagamos, digamos y oigamos para poder recuperarlo en algún momento. Antes Google recolectaba lo que hacíamoso en su buscador. Ahora OpenAI recolectará todo lo que digamos, que mola mucho más. Al menos, para ellos.

Esto pinta desde luego a un producto curioso. Yo soy más de gafas, pero esas son algo más obstrusivas. Es probable que haya sitio para este y otros tipos de producto, pero una cosa está clara: en todos ellos las pantallas pasarán a un segundo plano.

Y lo que triunfará, al fin, será la voz.

Actualización (26/05/2025): Muy apropiada la columna escéptica de Six Colors indicando que Jony Ive triunfó como diseñador gracias a que Steve Jobs le paraba los pies y ponía la función por encima de la forma. A este hombre lo que siempre le ha importado es lo contrario. Yo celebré su salida de Apple, y coincido con la reflexión enlazada. No hay que descatar que hagan algo interesante, pero Altman es el hype maker por excelencia. Mejor estar preparados para una decepción colosal.