Esta semana toca hablar mucho de OpenAI —mañana también lo haré probablemente, llega GPT-5, señores—Lo hice el lunes casi por casualidad, pero es que estos dos lanzamientos de la empresa son bastante llamativos.

El primero, por supuesto, es el de sus modelos abiertos. Prefiero calificarlos así que «Open Source», porque aquí tenemos la tendencia general, que es la de publicar los pesos utilizados y qu edeterminan cómo se procesan las entradas para producir modelos. Son importantes, pero no se comparten datos de entrenamiento, el proceso detallado o el código de entrenamiento, que permitirían replicar ese modelo.

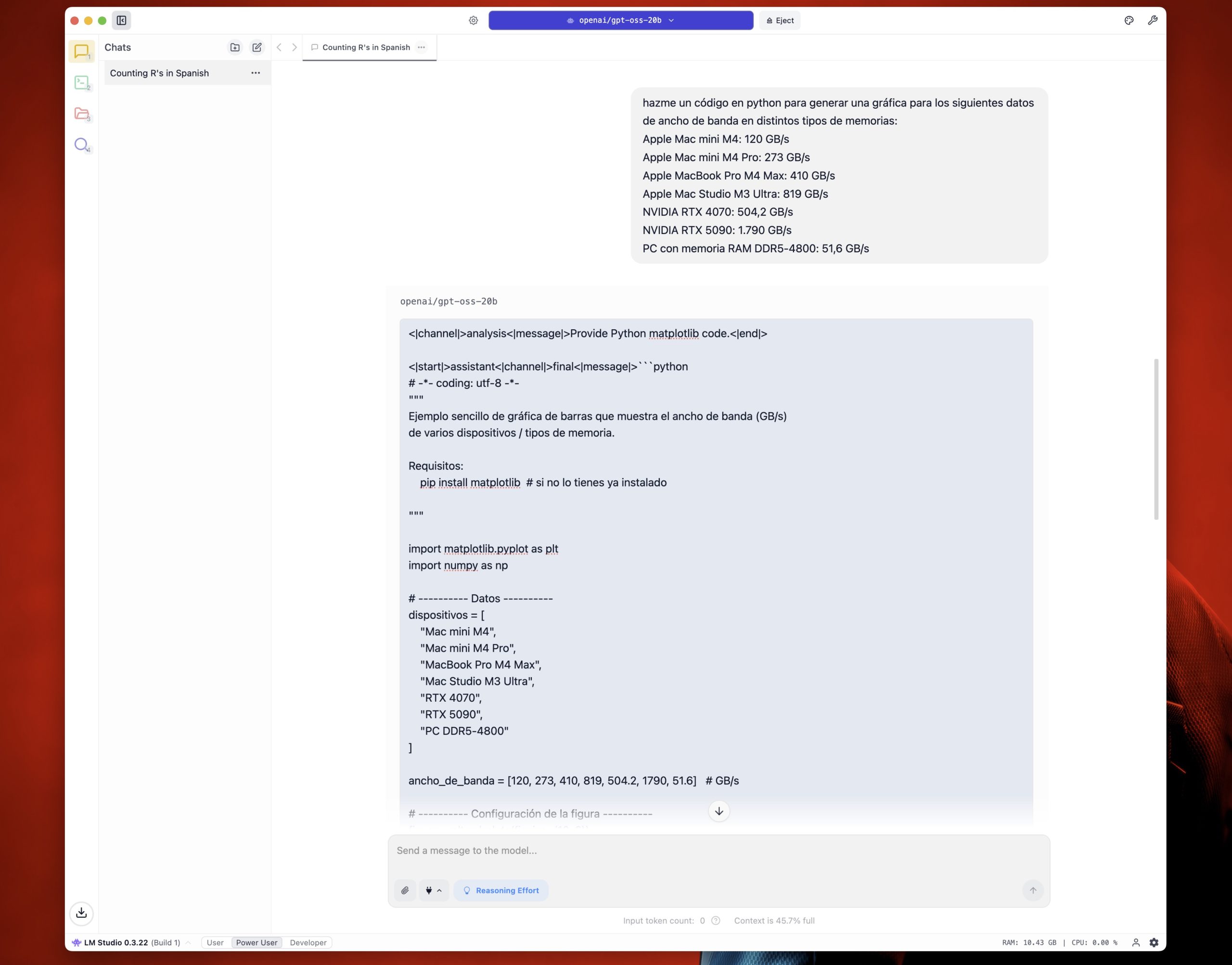

El caso es que tenemos con nosotros gpt-oss-20b, que se puede ejecutar en máquinas con 16 GB de memoria, y gpt-oss-120b, que se puede ejecutar en máquinas con 80 GB de memoria. Yo no puedo probar el segundo —me falta mi workstation de 12.000 euros— pero sí puede probar el primero en mi Mac mini M4 de 16 GB de memoria unificada.

Precisamente conté la experiencia ayer en Xataka así que no quería extenderme mucho, que allí ya lo hice suficiente. Mis conclusiones rápidas, por si os sirven de algo, son claras.

Una vez bien ajustado para mi máquina, el rendimiento fue sorprendentemente bueno. Usable, razonablemente rápido (pero ni de lejos tanto como ChatGPT/Claude/Gemini en la nube) y más que razonablemente correcto (pero inventa mucho y no tiene búsqueda en tiempo real en internet, aunque eso se puede apañar con algo de trabajo friqui.

Pero es probable que no sea ni de lejos el mejor de los modelos abiertos disponibles que uno puede ejecutar en local. Aquí Llama parece habernos dejado un poco tirados —era el más destacable— y ahora los modelos chinos son los más recomendados en el subrredit r/localllama. Y entre todos ellos, Qwen3, del que acaba de salir una versión que he probado esta mañana un momento y que es 4B (no 20B y va realmente bien. No sabría decir si tanto como gpt-oss-20b porque no he comparado mucho, pero promete.

En cualquier caso, lo que tengo claro es que lo de ejecutar modelos locales tiene mucho sentido para quienes amamos lo de montárnoslo por nuestra cuenta sin depender de la nube. No solo eso: esos datos se mantienen privados, así que no hay que temer que se queden en los servidores de los OpenAI/Google/Meta de turno.

Pero es que además apuntan a un futuro en el que se comportarán muy bien incluso siendo más pequeños y necesitando menos recursos. Así que esto apunta a un futuro prometedor para su ejecución en PCs y portátiles, pero también en móviles y quizás hasta en gafas. Entiendo que ahí para muchas cosas habrá que tirar de modelos en la nube —sobre todo cuando hay interacción visual, «qué es eso a lo que estoy mirando», mucha información pesada—, pero ojo que todo avanza.

Entre eso y el hecho de que los agentes de IA del tipo «máquina, haz esto por mí» cada vez están más cerca, vuelvo a la misma idea de mi post del lunes:

Mi optimismo con la IA está a tope.

¿Como haces para que gpt-oss-20b consulte en Internet? lo puedes decir?

Esta mañana le pregunte al modelo y me dijo que no puede…