Hace mucho, mucho tiempo, en una galaxia muy lejana, el reconocimiento de voz no funcionaba. Lo hacía para cosas muy básicas, sí, pero hablar con tu ordenador o, más tarde, con tu teléfono, no servía de mucho. A mí, por ejemplo, me daba hasta vergüenza.

Pero hablar con las máquinas parecía inevitable. Al menos es lo que nos decían desde las series y películas. El capitán Kirk lo hacía con una soltura pasmosa, y todos soñábamos con hacer lo mismo. En las pelis, por supuesto, todos seguían haciéndolo. Lo hacía el joven David Lightman en ‘Juegos de Guerra’, lo hacía Dave Bowman en ‘2001: Una odisea del espacio’ y, por supuesto, lo hizo Theodore en ‘Her’.

Aquella fue la película que probablemente mejor describió nuestro futuro a corto plazo. Por dos cosas: por hablar con las máquinas, y por enamorarnos de ellas. Hablaba de esto último hace poco en una larga conferencia en inglés con un conocido de EEUU —necesitaba consejo sobre mi visión de la IA en España para un proyecto—, y es algo de lo que ya he escrito mucho aquí en posts como ‘Tu mejor amigo será una IA‘ o ‘Los hombres que hablaban solos‘.

Pero lo primero, hablar con las máquinas, parecía seguir estando algo lejos. Y entonces, en mayo, OpenAI nos presentó GPT-4o y vimos cómo por fin la pregunta no era si hablaríamos con las máquinas. La pregunta era cuándo lo haríamos. Y viendo esas alucinantes demos, la respuesta es clara. Muy pronto.

Yo lo he hecho esta mañana.

No gracias a OpenAI. Su modelo de voz avanzado —el que presentaron en mayo— al fin está disponible, pero yo he ido a otra opción. A la de Google, que esta semana presentaba a bombo y platillo Gemini 2.0 y un montón de novedades asociadas.

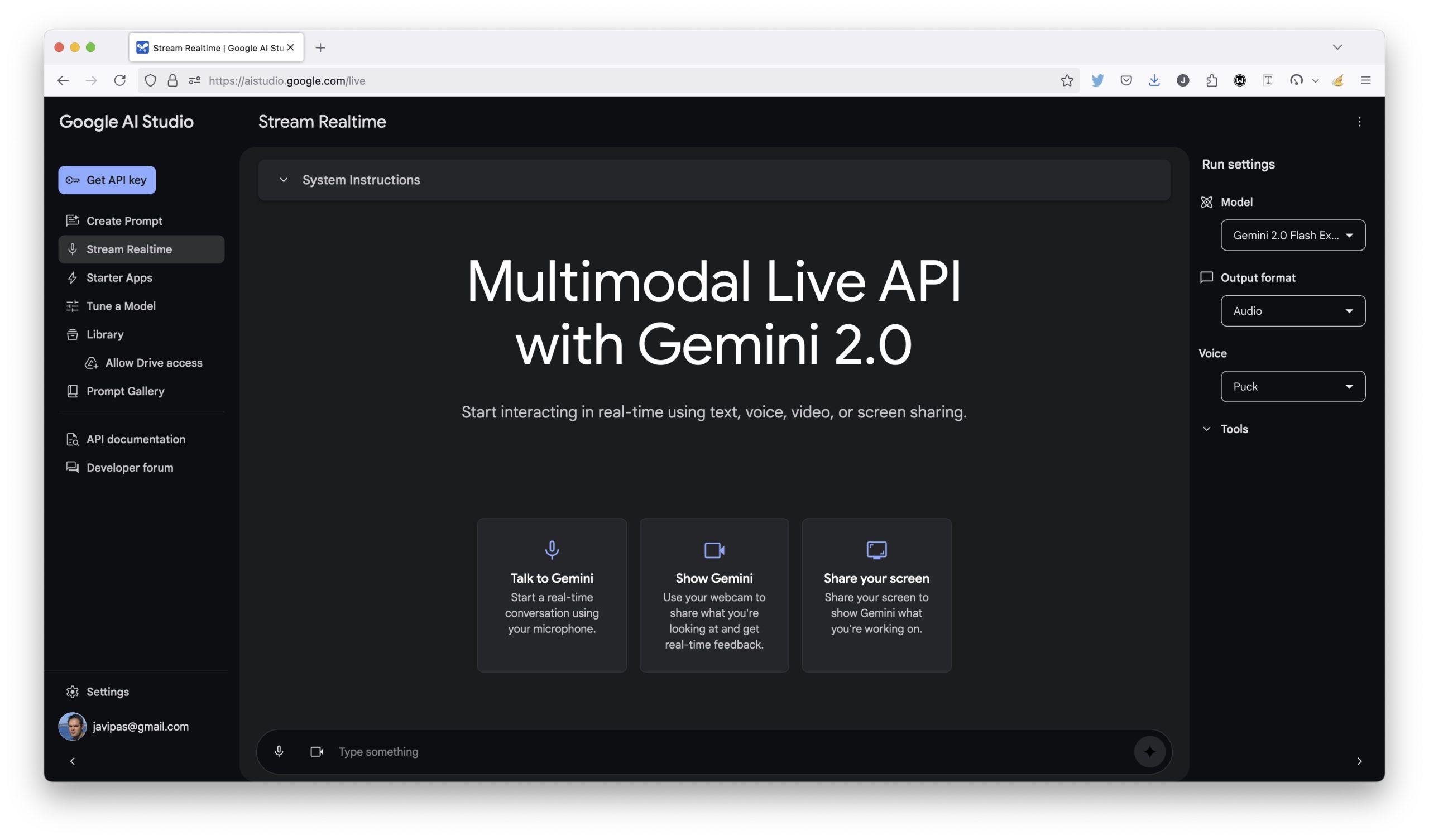

Y entre todas ellas, una especialmente alucinante. Su Multimodal Live API, que permite que 1) Gemini vea lo que ve tu webcam y 2) Gemini vea tu pantalla. Y en ambos casos, la interacción con el chatbot puede ser a través de texto, pero también a través de la voz. Puedes probar estas opciones totalmente gratis en Google AI Studio, y es alucinante hacerlo.

Insisto. Es alucinante.

Yo no tuve tiempo para hacerlo hasta hoy, pero estos días veía los vídeos de la gente que lo estaba probando en Twitter y, como digo alucinaba. Es fácil entender la repercusión de esto, sobre todo porque es solo el principio de todo lo que se nos viene.

Que no es ni más ni menos que la era en la que hablaremos con las máquinas.

Lo haremos con el ordenador, como lo he hecho yo, pero también con el smartphone. En realidad hay gente que lleva haciéndolo un tiempo. Gemini y ChatGPT ofrecen este tipo interacción desde hace algunas semanas en el móvil por ejemplo, pero lo de Google va a más. Y va a más porque que vean lo que tenemos en pantalla (o lo que vemos nosostros a través de una cámara) lo cambia todo. Otra vez.

Tengo que hacer muchas, muchas más pruebas, pero lo primero que se me ha ocurrido es algo muy básico: compartir pantalla mostrándole la ventana de Microsoft Edge con mi blog, y pedirle que leyera los primeros párrafos, pero traduciéndolos directamente al inglés. Lo ha hecho de forma inmediata y casi, casi perfecta.

Para mí esto es alucinante porque es, como digo, solo el principio. Ya lo habíamos visto un poco con Anthropic y su Computer Use, pero eso va un poquito más allá, como comento un poco más adelante. El caso es que las implicaciones y aplicaciones parecen ilimitadas —para bien y para mal, me temo— y permiten que ahora que la IA puede ver lo que tú quieres que vea, puede asistirte y ayudarte en un montón de situaciones. ¿Ejemplos?

- Mucha gente yéndose a hacer una ruta turística, con los cascos puestos y el móvil apuntando a un sitio o monumento, y preguntándole a la IA que le cuente cosas sobre ese sitio. Mal rollo para los guías turísticos.

- Un desarrollador software dejando que la IA ve lo que está haciendo en pantalla para que le corrija. Buen rollo para los desarrolladores (que sobrevivan).

- Un usuario perfeccionando su inglés, conversando y pidiéndole a la IA que le diga si ha pronunciado mal una palabra o se ha expresado mal. Mal rollo para Duolingo y las academias/profes de idioma.

- Una persona en casa haciendo la receta con unas gafas tipo Meta Ray-Ban y hablando con el asistente mientras le guía en la preparación —»¿he echado suficiente sal?»—.

- Y así, hasta el infinito y más allá.

Esto es como digo solo el comienzo, porque esto de hablar con las máquinas va a ser cada vez más natural, y viendo esto yo diría que antes de que acabe la década va a haber:

- Mucha gente con gafas, porque (a pesar de lo que dije) se van a convertir en una forma fantástica de interactuar con la IA y el entorno.

- Mucha gente hablando con máquinas.

Y digo mucha por no decir toda. Y la otra gran pieza del puzzle es la de los agentes de IA, de los que no paro de hablar en Xataka pero que no solo van a hablar con nosotros, sino que van a hacer cosas por nosotros si pueden. En plan «resérvame un viaje a París el fin de semana que viene con un presupuesto X» o, como sucede con los nuevos IDEs de código como Cursor, «hazme una extensión en Firefox que me permita que todo lo que publico en Twitter se publique en Bluesky». Si es posible hacerlo, lo hará.

Y todo, como digo, hablando.

Como si fuéramos el capitán Kirk.

Alucinante.

Al final nos vamos a volver tontos y no sabremos hacer nada por nosotros mismos 🙁

Un poco sí.

Hola Javi. Es la primera vez que comento, así que vaya por delante que me encanta tu contenido.

Ahora estarás esperando el «pero» xD Bueno, sí, un poco, pero es por contraste. Yo también alucino bastante con las cosas que se pueden hacer con la IA generativa, pero, desde que leo a Ed Zitron, gracias a un artículo tuyo, mi visión es mucho más pesimista, porque no puedo dejar de cuestionarme la sostenibilidad del modelo de negocio (y ambiental) detrás de cada cosa que hagamos con la IA. Me he vuelto un pesimista de narices con estas cosas.

Un saludo, y gracias por todo lo que escribes.

Hola Pablo, buen bienvenidísimo a los comentarios, gracias por animarte.

Pues debo decirte que a mí Ed Zitron me parecía interesante y coherente, pero también tiene mucho de hater radical. Y eso implica que está en un extremo, que lo veo todo blanco o negro. No soy nada fan de esa forma de ver las cosas, y aunque puede que tenga razón en algunas cosas, no me ha acabado de convencer de que me vuelva un pesimista crónico como él. Yo soy más bien tecnooptimista, pero por supuesto cada cual tiene su visión.

Saludos!

Jopelis, Javi!

Recién levantado y ya dándome ideas para llevar a clase para que los estudiantes aprovechen todas las potencialidades de la IA y aprender más y mejor. Así no hay quien viva 🙂

Muchas gracias por el input!!!

Qué bien Fabri. Cuéntame, cuéntame, ¿a qué edades das clase? ¿Qué tal la respuesta y la experiencia? Tengo curiosidad 🙂

Yo doy clases a nivel universitario. Y la experiencia con la IA en general y con la IAGen, muy bien: se puede usar para comprobar algo (por ejemplo la pronunciación/sintaxis, de unas frases en lengua extranjera), completar, motivar, cruzar información, generar plantillas de evaluación para ver si sobre el mismo tema las plantillas generadas por humanos tienen las mismas características… con la IA hay un mundo de posibilidades. Mucho depende de los docentes, y de su preparación pedagógico/didáctica.

Ahhh qué bueno. Como dices, hay muchas opciones ahí, desde luego, y se pueden aprovechar mucho y bien. Bien por hacerlo!

Uff yo al principio de arranca la IA tuve muchas, pero muchas discusiones/debates con compañeros que argumentaban que eso no dejaba de ser un programa que respondía los datos que tenía grabados, pero es que, no entendían lo que venía de camino.

Ahora, con el tiempo, se me ha dado la razón y para variar, ahora saben todos un montón sobre el tema, pero eso es un tema para otro momento y debate café en mano.

Yo lo vivo a diario porque las uso y mucho, soy el único en mi departamento y recurro infinitas veces a la sapiencia de chatgpt y estos días, con el calendario de adviento de IA, he estado probando cosas y es que se me vislumbrar cosas por venir que no se si me fascinan o me aterrorizan.

Hemos vísto «Her», al menos la mayoría… pues estamos casi a las puertas si no ya en ellas, pero voy mas allá, unas gafas, tan criticadas por todos, yo incluído, unas gafas y el entorno que te rodea ya podría ser lo que fuera que tus gafas y la IA ya se encargan da moldearlo a tu/su gusto.

Imaginemos ir por la calle y un cartel podría ser perfectamente blanco y al pasar por delante y detectar «nuestras cookies xDD» mostrar el anuncio de turno, gente con avatares… pufff

Pero es que ya el tema conocimiento va a ser una barbaridad, tener unos auriculares de transmisión osea que sepa antes que tu lo que tienes que responder o que traduzca al instante lo que te están diciendo, ya daría igual con quien hablaras, todo dependería del lag de tu dispositivo xDD

En fin, es fascinante, como te he dicho, actualmente es mi compañer@ de trabajo, todos los días le paso errores de powershell, de windows, de linux… ya no busco en google, pero es que, ya ni escribo lo que pregunto.

Que tiempos nos ha tocado vivir.

Bien dicho Víctor, efectivamente tiempos súper emocionantes y, en parte, inquietantes. Vienen curvas, para bien y para mal. Esperemos sortearlas y salir bien de esto, porque ciertamente las posibilidades positivas son enormes.

Javier, una newsletter que es top sobre IA y aprendizaje, sociedad, ética y mil cosas más es https://www.downes.ca/news/OLDaily.htm, de Stephen Downes, un crack sobre estos temas, con el pensamiento crítico muy bien desarrollado, y que puede ayudar a sortear las curvas que vienen… Saludos y gracias siempre por conpartir

Hola chicos, estamos ante otra revolución «industrial?». Porque comenzó-es-será un cambio tan drástico de la forma que hemos estado viviendo que seremos nosotros como hoy lo son nuestros familiares centanarios, un recordar de cómo fue la manera de pensar y actuar ante la vida, y que es totalmente diferente. Y eso que en estos momentos la tecnología ha pasado de los pañales y está comenzando a tener las hormonas un poco alteradas.

Lo importante es siempre tener presente que la tecnologia «es una ayuda» y que yo como persona he de saber cosas mínimas, sobre todo las que me ayuden a subsistir por mi mismo.

Recordemos que tenemos delante a una fauna y flora que sin tecnología llevan miles y miles de millones de años viviendo en la tierra, y las personas no llegamos ni a su 10%.

Por eso la pregunta que me planteo es: Podremos vivir nosotros así, sin tecnología?.

Porque recordemos que hemos aprendido hablando, leyendo y escuchando a personas que también tienen nuestras virtudes y defectos. Pasará esto mismo con las máquinas-robots-IA’s, que supuestamente serán mas perfectas que nosotros?

Uf preguntas díficiles José María. Pero yo diría que sí, que estamos ante otra revolución industrial. Una que, como bien dices, tiene las hormonas un poco alteradas 😛 Saludos!

Offtopic: en mi Firefox me salen iconos gigantescos de emojis.

Viendo las propiedades del HTML:

Si elimino el src «loquedea.svg» se muestra el «alt» (a un tamaño correcto) y no el mega-emoji.

Gracias Hergest, apuntado, lo curioso es que a mí no, quizás por alguna extensión pero a ver si me salen alguna vez y así puedo corregirlos.

Pingback: Gracias, Reyes Magos, pero las Meta Ray-Ban no son para mí (de momento) | Incognitosis

Pingback: Máquina, hazlo tú por mí | Incognitosis