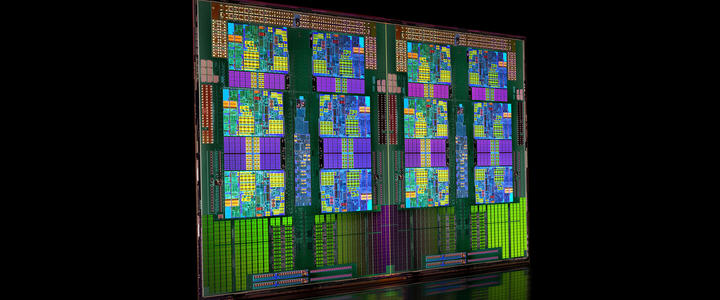

AMD ha presentado hoy sus Opteron 6200, que forman parte de la familia Interlagos, y que llevaban tiempo prometiendo un logro que hace unos años hubiera sido probablemente considerado como una utopía: ofrecer 16 núcleos de proceso independientes. ¿Cuál ha sido la cobertura en prensa? Mínima. La razón es clara: la batalla por el gigahercio ya no interesa al gran público friki, y tampoco parece hacerlo ya la batalla por el micro con más núcleos o ‘cores’. Porque lo que ahora está de moda es la eficiencia.

De hecho, los chips de la familia Interlagos no es que sean unos tragaldabas energéticos: la nueva arquitectura Bulldozer sirve para dar más por menos, y eso afecta a un consumo bastante decente (entre 85W y 140W), sobre todo si consideramos toda la potencia que es posible sacarle a estas bestias del proceso.

Lamentablemente nos enfrentamos al mismo problema de hace años, cuando comenzó la fiebre multicore: no hay aplicaciones prácticas que saquen provecho de estos micros, y salvo en contados escenarios -virtualización, probablemente, el más manido- los micros multicore tienen pocos argumentos para causar asombro o expectación. La eficiencia y el ahorro están a la orden del día, y los micros ARM que comienzan a usarse en algunos servidores -y la cosa va a más- están dejando claro que la crisis mundial nos ha hecho pensarnos a todos en lo de que no necesitamos un Ferrari si luego vamos a tenerlo que llevar a 70 por la M30.

No es simplemente que no se puede activar multi-nucleo en cualquier aplicaciones; cada vez más aplicaciones son más exigentes en cuestion de CPU/ram y aún con 16 núcleos irán igual de lentos

Los que manejamos servidores y virtualización, ya te digo si está bien el bicho este. La virtualización lo es todo cuando hablamos de servidores … no se me pasa por la cabeza como muchas empresas aquí no la usan. Las ventajas son infinitas. Evidentemente, para un FreeBSD con Apache no aporta demasiado.

Otra cosa es que en España en general nadie tenga ni puñetera idea (por no decir ni put…) y las empresas compren un Xenon de 6 nucleos con 2 Gb para desperdiciarlo al 90% instalandole un sistema operativo cualquiera, cuando a la misma máquina metiendoles unos gigitas de RAMy un ESXi podrían consolidar 10 o 15 servidores. Pero eso es otra historia …

Esto estaria bien en consolas por ejemplo. Pero viendo que el futuro de las mismas (Loop) es el mismo que el ejemplo del Ferrari como que no. Igual dentro de dos generaciones, cuando la cosa se recupere?? pueda ser un aopcion.

Pues decir sin más que un procesador tiene 16 cores es como decir que un coche tiene un motor de 12 cilindros. Que da una idea de lo grande que es pero no sabemos más. Y puede que haya otro motor de 6 cilindros con la misma o más potencia si lleva turbo y el de 12 es atmosférico.

¿Que quiero decir con eso? Pues muy sencillo, sin conocer más detalles, decir 16 cores es más un movimiento de marketing que otra cosa. Qué cachés tiene, cómo van montadas, si son compartidas por varios cores o no… cuantos niveles de pipeline, velocidad de reloj, entre otros detalles importantísimos para valorar el rendimiento de un procesador.

¿Importa que un procesador tenga 16 núcleos? Depende de lo que les acompañe y cómo esté diseñado el procesador en cuanto a las características que definen su rendimiento.

Hay que ver los benchmarks, pero me suena que esto es mucho bulto y poco rendimiento, que al final es lo que importa. En el plano de los CPUs AMD no acaba de convencerme, por muchos núcleos que pongan.

A pesar de que aunque al principio puede parecer que no, seria mejor tener uno solo con la potencia de los 16, porque no toda tarea es paralelizable, pero como hoy en dia no se puede conseguir esa potencia, por temas fisicos, entre otras cosas, pues es lo unico que se puede hacer. Dicho esto pues si que importa.

¿ y porque importa?, pues porque un sistema operativo tiene muchas tareas y pueden dividirse esas tareas en los 16 nucleos, tambien porque en un ordenador no solo tenemos una aplicacion abierta. Que es verdad que la mayoria de las aplicaciones no son multihilo, pues si, pero cada una de las que esten ejecutandose puede ejecutarse en un nucleo/hilo.

En tiempo trabaje con ordenadores con 2 opterones, creo que tenian 4 nucleos cada uno (no me acuerdo), y la aplicacion que diseñamos fue linkada con las librerias multihilo, es verdad que nuestra aplicacion no corria mucho mas, pero los nucleos no permanecian ociosos, pues ademas estaban ocupados con tareas del sistema operativo, aparte de algunas de nuestra aplicacion. He de decir que teniamos abundante memoria y que el disco duro solo lo usabamos al principio y despues a calcular y dibujar, lo comento porque como hoy en dia el gran cuello de botella es el disco duro o la manera de acceso a estos y que todo parece tirar de bases de datos (en disco duro, y algunas gorda), «to kiski» parece mapear ficheros en memoria (que no es mas que memoria virtual encubierta) y parece que eso de las estructuras de datos hechas por uno mismo en la memoria no se lleva, pues al final puede que toda la potencia se pierda por aqui.

Saludos

Se me olvido:

Eso si, hoy en dia puede que estemos mas preocupados por el consumo que por la potencia, porque para usos normales tenemos unos «peazos de cacharros».