Mi última obsesión no es la de montarme una alternativa a Google Photos. Como sabéis eso hoy por hoy lo tengo resuelto. Lo que me gustaría es poder correr modelos de IA en local, sin conexión a la nube, sin que ChatGPT o el resto de modelos supieran lo que quiero de ellos.

Ahora mismo lo saben, y eso me preocupa, así que busco alternativas.

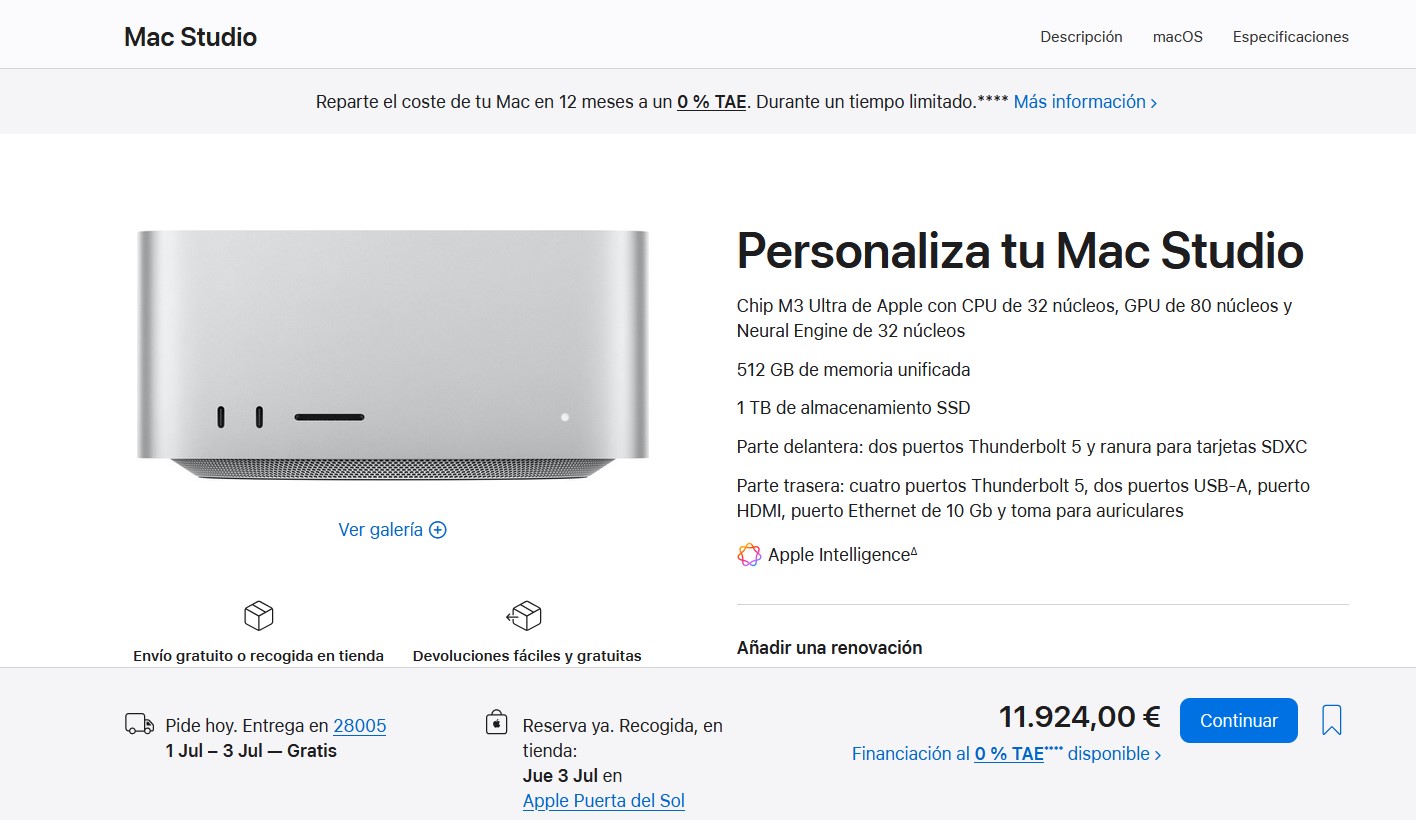

Pero hay un problema. Que las buenas alternativas son caras. Mucho. De hecho para mí solo hay una realmente factible hoy en día. Esta.

Seguramente me diréis que de qué voy. «Javipas, no te flipes. Puedes correr tus propios modelos por mucho menos».

Claro que puedes. Pero esos modelos no suelen demasiado capaces. Están bien para juguetear y hacer cosas básicas, pero no son comparables a los que encontramos al usar ChatGPT o Claude. Si quieres una alternativa real a esos modelos, necesitas dos cosas:

- Mucha memoria de vídeo

- Mucho ancho de banda

Todo lo demás no importa tanto. Por supuesto que tener una buena GPU es relevante, pero el verdadero cuello de botella para los grandes modelos de lenguaje es la memoria. Cuando usas un modelo de lenguaje en local, necesitas cargarlo en memoria de vídeo para que vaya realmente rápido, y la memoria de vídeo suele ser escasa. Mi PC de sobremesa tiene una RTX 2080 Super, que no es mala gráfica para jugar, pero que solo tiene 8 miserables GB de memoria gráfica. La RTX 5090 tiene 32 GB, una cifra bastante decente pero de nuevo insuficiente para los modelos realmente potentes.

Esos modelos de IA suelen «pesar» bastante más. DeepSeek-R1-0528, la versión más potente y capaz de ese modelo chino, ocupa 715 GB en disco (y en memoria). No se puede correr en ninguna máquina de consumo actual, de hecho: solo combinando (con Exo) varios Mac Studio M3 Ultra (por ejemplo) podrías hacer algo así. Hay quien lo ha hecho (aunque con Llama 3.1 405B) y esa es para mí la idea. Poder hacerlo. Hay otro modelo chino especialmente llamativo, Qwen3-235B-A22B, pero de nuevo, correrlo de forma fluida en una máquina normal es casi imposible. Alex Ziskind explica bastante bien cómo es correr modelos de IA en local con el M3 Ultra frente a un clúster e incluso frente a una gigantesca RTX 5090.

Pero no para el Mac Studio M3 Ultra con 512 GB de memoria unificada. Con esa cantidad de memoria uno puede utilizar prácticamente cualquier modelo de IA sin necesidad de usar versiones cuantizadas (palabro), que reducen la precisión de los pesos del modelo y por tanto su propia capacidad para contestar de la forma más correcta. Hay otras técnicas para «comprimir» los modelos y que no pesen tanto (poda (pruning), destilación, formatos eficientes como el GGUF de Llama), y aunque desde luego son muy útiles y pueden no impactar demasiado en las prestaciones, siguen siendo versiones algo capadas. Y yo querría jugar con los modelos sin más. O intentarlo.

Pero como digo, no es fácil si no tienes una máquina con muuuucha memoria de vídeo que además debe tener muuuucho ancho de banda. Por poneros en situación, no hay ninguna máquina comparable a los Mac Studio M3 Ultra con 512 GB de RAM y ancho de banda de 819 GB/s. O sí, pero es también de Apple: los Mac Studio M2 Ultra, que cuentan con una versión mucho más modesta en cuanto a cantidad de memoria (192 GB como máximo) pero que pueden presumir de ese mismo ancho de banda de memoria (819 GB/s, insisto).

Aunque no lo parezca, ese ancho de banda es crucial para que el modelo sea mucho más rápido a la hora de generar la respuesta. Cuanto más ancho de banda, «más rapido escribe». Y si quieres una experiencia fluida, quieres que escriba rápido. Para que os hagáis una idea, mi Mac mini M4 tiene 16 GB de memoria unificada a 120 GB/s. Los M4 Pro llegan a los 274 GB/s, y los M4 Max, a 410 GB/s. De primeras y sin contar nada más, los M3 Ultra (y M2 Ultra) generan tokens unas 8 veces más rápido que mi Mac mini.

Las alternativas, que las hay, son peores. Las citadas RTX 5090 tienen un ancho de banda de memoria fantástico de 1,79 TB/s (el doble que la de los M2 y M3 Ultra), pero tendrías que combinar varias —por ejemplo cuatro— para tener 128 GB en total, pero id preparándoos para un monstruo complejo de montar y que además destaca por consumo, ruido y por supuesto coste.

Quizás me digáis algo tipo «¿y qué pasa con la memoria RAM? ¡Es mucho más fácil y barato ampliarla en un PC!». Cierto, y también es una chusta. La memoria DDR5 ronda los 120 GB/s en doble canal, más o menos como mi Mac mini M4, y ahí entran en juego cosas como la NPU o, por supuesto, que tengas una gráfica dedicada maja en el PC. Aun así, insisto, «cargar» el modelo en memoria principal hace que todo sea mucho más lento, así que te limita.

Hay una opción. AMD presentó hace unos meses sus Ryzen AI Max+ 395, que destacan especialmente porque la NPU no está mal, pero sobre todo porque están siendo usados para ofrecer alternativas al Mac Studio. Por ahora hay dos. La primera, el Framework Desktop, que ya ha sido anunciado pero no llegará a usuarios hasta el tercer trimestre del año.

La segunda, el GMKTec Evo X2, que está a la venta. Ambos ofrecen versiones con 128 GB de RAM por 2.359 euros y 1.999 euros respectivamente, y lo curioso de estos equipos es que esa memoria RAM es lo más parecido que tenemos a la memoria unificada de los Mac. De hecho, puedes elegir cuánta (dentro de unos límites) asignas como memoria de vídeo y cuánta como memoria principal. Y como sucede con los Mac, esa memoria está formada por módulos LPDDR5X soldados en placa, así que de ampliaciones nada. Pero como digo, puedes hacer que 96 de los 128 GB se comporten como memoria de vídeo, lo que da bastante margen de maniobra para trabajar con modelos de IA más potentes. Aquí de nuevo Alex Ziskind —al que sigo en YouTube precisamente por este tema—hacía pruebas chulas:

El único problema es el ancho de banda. En ambos equipos ese ancho de banda es de 256 GB/s, que no está mal del todo (al nivel de los M4 Pro), pero sigue estando lejos de los M2 y M3 Ultra. Y claro, eso se notará si quieres trabajar con modelos pesados, que seguramente escriban en modo caracol.

Por supuesto aun teniendo un Mac Studio M3 Ultra de 256 o 512 GB no te aseguras tener algo que compita completamente con los chatbots que tenemos en la nube. Para eso en realidad necesitas que también puedan acceder a internet para buscar info para ti y la sinteticen si lo necesitas, y ahí entran en juego el llamado Retrieval Augmented Generation o RAG, que no tengo ni idea de qué tal funcionan pero que no deben portarse mal.

Pero todo eso da igual, porque no pienso gastarme 12.000 euros en un Mac Studio M3 Ultra con 512 GB de RAM. Estuve incluso mirando los M2 Ultra, pero no salen a cuenta —siguen siendo carísimos porque la gente se ha dado cuenta de que molan para IA, y lo de gastarme 2.000 euros en una máquina «pobre» en ancho de banda tampoco me llama demasiado la atención. Así que probablemente no me gaste nada durante una buena temporada y espere a ver si el mercado hace lo que tiene que hacer: abaratarse para que los pobres mortales podamos hacer este tipo de cosas sin tener que hipotecarnos.

La alternativa real, por supuesto, es no montarme mi ChatGPT en local porque ya tenemos uno estupendo online. Es la decisión fácil, claro, como también lo es usar Gmail o cualquier otro servicio gratis en el que no pagas dinero porque pagas con tus datos. Aquí mi otra esperanza es que aparezcan chatbots privados y asequibles. La propia OpenAI tiene —como otras— su ChatGPT Enterprise con políticas ZDR (Zero Data Retention), y para mí aquí Apple tiene una oportunidad de oro. Lo comentaba en 2023 al hablar de la privacidad, y desde luego su enfoque va por ahí con su Private Cloud Compute si sacan un modelo que todos podemos usar (que veremos si será exclusivo para usuarios de su ecosistema). Pero esto es todo especulación. De momento lo fácil y razonable es usar los modelos gratuitos y, si lo necesitas, las alternativas de pago para evitar límites de uso.

Dicho lo cual, seguro que alguno tiene comentarios y sugerencias en este tema. Estoy súper interesado en leeros, así que, adelante 😛

El principal problema que le veo es el de la obsolescencia: vale, te sobra la pasta y te das el gusto de tener tu propio ChatGPT. ¿Cuanto tiempo va a pasar antes de que ese equipo sea una castaña que ya solo pueda correr modelos obsoletos? ¿Un año, dos a lo sumo?

Es otro problema, sí. Gastar mucho dinero en lo último de lo último es mala decisión en tecnología, porque lo último de lo último cambia muy rápido.

El Mac Studio M2 Ultra es de junio de 2023, por ejemplo, y aunque mola por su ancho de banda de memoria, «solo» permitía 192 GB. Ahora 512 GB. Dentro de dos años qué, 1 TB y con memoria aún mejor ? Es perfectamente posible, así que sí, esa inversión duele aún más.

Tal vez un PC que en vez de montarle una gráfica de consumo normal, montarle 4 tarjetas RTX PRO 5000 Blackwell 48GB GDDR7 (que logicamente sale por un pastizal, 16 mil pavos las 4 GPU), te debería ser suficiente ancho de banda (1344 GB/s) y cantidad de memoria (192gb, debería poder ser perfecta para modelos 70B o incluso 120B).

En webs de equipos workstatión rollo Azken, se pueden montar equipos bastante potentes (y caros) con esas gráficas.

Y no solo es el coste, también el monstruo que tienes en casa o la ofi con el ruido, calor y energía que consume. Que puede ser superior, claro, pero a mí el M3 Ultra me parece inigualble para usuarios domésticos con ganas de probar estas cosas. Silencio (casi) total, eficiencia total. Solo por eso gana aunque sea menos potente (y más barato).

Sí, según lo explicas en el articulo, no es mala opción para esa función. Pero claro, si 16 mil euros es muy caro, 10 mil tampoco es que sea barato, no sé hasta que punto, un uso personal, podría justificar ninguno de esos gastos (bueno claro, al que sobre mucho el dinero).

A nivel empresa, pues seguramente en vez de los 10 mil, sería mejor tirar por la opción más cara porque generalmente el silencio o eficiencia energética puede estar en segundo plano si técnicamente la IA en local funciona mejor.

Hola javipas,

al hilo de intentar no usar servicios gratuitos y correr lo que se pueda en local o pagando, como Google Photos que mencionas, ¿de qué más has conseguigo independizarte y cómo?

Un saludo

Hola. Intenté montar un servidor de correo pero era demasiado complejo. En mi máquina Unraid voy jugueteando con cosas, y hay de todo, pero por ejemplo Nextcloud como sustituto de iCloud/Google Drive y Keepass XC como alternativa a 1Password/Lastpass. Navego con Firefox y busco con DuckDuckGo (aunque sigo usando Google según el momento), pero es muyyy difícil escapar de todo. Al final mi dependencia de Google en otras cosas (correo, mapas, youtube) es total.

Muy interesante Javi.

Me pregunto si a mi empresa no le interesaría tener un repositorio de toda la información de sus proyectos gestionados con una IA local, independiente de la nube.

A nivel doméstico lo considero un poco obsceno (no sé si es la palabra) pero demasiado coste para no tanto beneficio. Pero a nivel empresarial no me parece una inversión descabellada.

Gracias Goyo, sí, diría que una inversión así para empresas es bastante interesante, pero claro, no para todos los usuarios porque eso eleva demasiado los costes. De todos modos a nivel empresarial como decía las plataformas saben que esas empresas necesitan que no haya fugas de datos sensibles, por eso lo que comentaba de la Zero Data Retention, así garantizan que tus datos no se almacenana jamás en la nube ni se usan para entrenar. Que luego te lo creas es otra cuestión.

También le he dado vueltas al tema y creo que molaría montar una cooperativa de gente guay que pague a pachas y con cero retención de datos.

Complicado, me temo. Pero supongo que no imposible.

Al final mucho criticar a Apple con la IA y va a ser la que mejor se lo ha montado xDDDDDD

Lo siento, estaba a huevo y tenía que soltarlo jejeje

En esto sí, desde luego, pero en esto simplemente se han encontrado con esa ventaja, no creo que la tuvieran en mente para este ámbito (y nunca lo mencionaron que yo sepa) 😉

Lanzo debate, ¿por qué nos empeñamos en cargar modelos con millones de parámetros y entrenados para tareas generales?, que entiendo que es más cómodo, pero también más costoso.

Cada vez más vamos hacia modelos más pequeños, entrenados en tareas concretas que puedan ejecutarse en local y aprovechar los NPUs (que evolucionarán y mejorarán con el tiempo), cómo en los teléfonos móviles, y bajo mi punto de vista ahí está la clave a nivel empresarial también.

De la misma manera que ahora puedes cambiar de modelo según la tarea, no veo descabellado hacer igual en local pero que los modelos sean más específicos.

Al final esta carrera absurda por ver quién saca el modelo con más millones de parámetros me recuerda a los principios en la carrera por los Ghz de los procesadores, para terminar dándose cuenta que la solución óptima era mas cores y trabajar en paralelo y no más Ghz.

¿qué opináis?

Esta noticia tal vez mejore el tema de la memoria en unos pocos meses.

https://www.phoronix.com/news/RadeonSI-SVM-Merged

Pingback: He probado gpt-oss-20b: así es el futuro de la IA local | Incognitosis