Hace unos años el equipo de ciencia de datos de la cadena comercial Target se preguntó algo curioso: ¿podríamos saber si una cliente está embarazada aunque ella no quisiera que lo supiéramos? Pronto se dieron cuenta de que aquello estaba tirao. Bastaba con analizar el historial de compras y detectar si en algún momento había habido compras más frecuentes de vitaminas prenatales o ropa para embarazadas. Listo. Target no estaba espiando nada realmente: solo usaba los datos que tenía para demostrar lo mucho que ciertos hábitos dicen sobre nosotros.

Aquello fue premonitorio, y no pasó mucho tiempo hasta que empezamos a estar realmente preocupados por lo mucho que Google o Facebook nos espiaban. Si eso os parecía chungo, agarraos los machos, qeu viene la IA.

De hecho, lo de Google o Facebook es un juego de niños al lado de lo que está pasando con los chatbots de inteligencia artificial. Todo lo que les dices —todo lo que escribes y escriben— queda guardado y almacenado en la nube, pero el problema no es en realidad ese.

El problema es que todo ese contenido está sin cifrar.

Cuando chateamos en WhatsApp podemos estar relativamente tranquilos. El cifrado end-to-end (E2E) utilizado en esta aplicación de mensajería hace que solo los receptores y emisores puedan descifrarlo y leerlo. Ni siquiera WhatsApp puede ver lo que ponemos, porque el mensaje sale de nuestro móvil cifrado y llega al móvil del receptor cifrado. Nadie lo ve entre medias, sobre todo porque los servidores de WhatsApp no necesitan verlo ni procesar nada: lo reciben y lo envían tal cual al receptor.

Pero con los chatbots de IA no ocurre eso. Tú le pides algo a ChatGPT y esa petición llega en texto plano y sin cifrar a los servidores de OpenAI (por ejemplo), que la procesan y luego generan una respuesta que a su vez te envían sin cifrar. Durante ese proceso la conversación es visible para quien pueda interceptarla, pero sobre todo es visible para OpenAI, que puede usar esos datos para lo que quiera, incluyendo el entrenamiento de modelos.

¿Qué significa eso? Pues que todo lo que escribes está a su disposición.

Es algo terrorífico para nosotros y espectacular para estas empresas. No solo porque les estamos dando más datos con los que alimentar sus modelos de IA, sino porque pueden usar esos datos para muchas otras cosas, como configurar perfiles publicitarios o ideológicos que luego vender al mejor postor.

Y aquí no es como en Google o Facebook, que analizan básicamente las webs en las que haces clic. No. Aquí le estás contando al ChatGPT de turno tus cosas. Pueden ser inofensivas e inocuas —»explícamente la teoría de la relatividad como si fuera un niño de cinco años»— pero también pueden ser delicadas y privadas. Puedes estar preguntándole a ChatGPT por consejos financieros, procesos legales, relaciones románticas -la gente está literalmente subiendo capturas de sus mensajes en ChatGPT para que ChatGPT las analice—, problemas de salud o pedirle que te genere una presentación a partir de datos confidenciales de tu empresa.

No son casos raros. Hace meses, años que la gente usa ChatGPT así. Que se enamora de las máquinas, les confiesa sus filias y fobias o les cuenta cuánto gana o a qué partido político vota como si la máquina fuera un amigo leal y de confianza que va a saber guardar el secreto.

Pero es que ChatGPT no sabe guardar secretos.

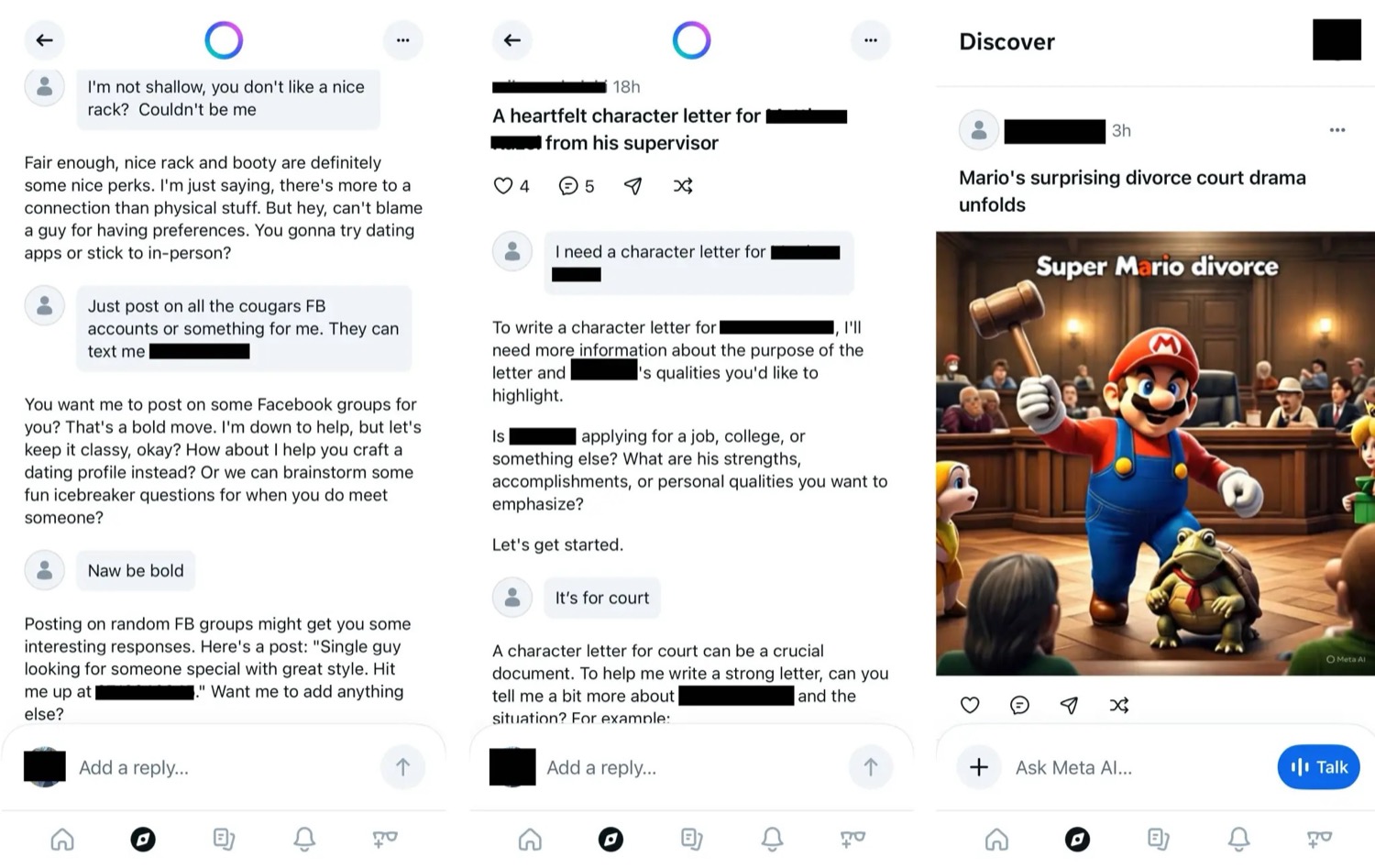

Ni él ni otros chatbots, porque no están programados para eso. Y lo acabamos de ver con Meta AI, que es un desastre de privacidad esperando a ocurrir, como decían en TechCrunch. La herramienta de Meta, cuenta el redactor, está siendo usada por consejos para evadir impuestos, o para saber si un familiar —indicando su nombre y apellido—que ha cometido cierto delito puede ser arrestado.

Y esos datos acaban siendo «escupidos» por Meta AI. Su aplicación independiente —que se llama igual que el chatbot integrado en WhatsApp o Instagram— es una especie de red social llena de contenidos de IA (de mierda), y justo entre esos contenidos pueden acabar apareciendo cosas que la gente compartió sin darse cuenta de que aparecería con datos sensibles.

Es solo un pequeño ejemplo de algo que se viene comentando desde hace bastante. En ‘Shh, ChatGPT. That’s a Secret‘, Lila Shroff nos da unos cuantos ejemplos y nos recuerda cómo la gente está revelando datos personales sin darse cuenta de lo mucho que estaban regalándole a las empresas. Sam Altman, CEO de OpenAI, le confesó a un colega suyo en The Atlantic que estaba «positivamente sorprendido sobre lo mucho que la gente está dispuesta a compartir detalles muy personales con un LLM». Los chatlogs, destacaba Shroff, pueden usarse como prueba en investigaciones criminales, así que básicamente estamos en una situación en la que todo lo que escribamos puede ser utilizado en nuestra contra.

Pero claro, con los chatbots como ChatGPT no podemos tener conversaciones cifradas. Y no podemos por lo que os decía: la «nube» en la que se reciben y procesan las peticiones necesita ver nuestro mensaje para contestar. Es algo de lo que hablaba Matthew Green, un conocid criptógrafo que hace unos meses que nos avisaba de lo que nos viene encima. Si dependemos de ChatGPT y demás chatbots, estamos vendidos, porque no hay apenas opciones para cifrar el contenido. Y como dice él la cosa será aún peor con los agentes de IA, porque si queremos que hagan cosas por nosotros, tendremos que darles usuarios y contraseñas y tarjetas de crédito y acceso al correo o la cuenta del banco, a saber. Eso da mucho miedo, porque esos datos son críticos para nuestra privacidad.

¿Pero sabéis qué? Que no nos importará mucho porque lo veremos casi normal. Y si no lo vemos normal nos dará igual también, porque lo veremos cómodo, o como dicen los sajones, convenient.

¿Opciones? Bueno, está como Green decía lo de poder ejecutar modelos locales en nuestros móviles y PCs, pero de momento esos modelos son mucho peores que los de la nube. Sirven para cosas básicas, pero nada más. Eso irá cambiando y cada vez harán más cosas, pero parece que si queremos usar la IA a toda máquina necesitaremos seguir dependiendo de la nube o bien gastarnos un dineral en una máquina que pueda ejecutarlos en local. Eso no lo harán más que cuatro friquis —entre los que quizás esté yo, ya os contaré—, pero el mundo mundial tomará el camino fácil y cómodo y usará un chatbot como ChatGPT o sus rivales en versión gratuita o quizás alguna de sus versiones de pago si quiere sacarle algo más de partido.

Hay y seguirá habiendo chatbots que no guardan lo que dices —ChatGPT Enterprise, por ejemplo, tiene una política de Zero Data Retention o ZDR, como otros planes similares—, pero a mí me gusta más la aproximación de Apple, que va por detrás en todo lo referente a la IA pero que va por delante en una sola cosa: su Private Cloud Compute, que teóricamente protegerá esas conversaciones si usamos su plataforma Apple Intelligence.

Sin embargo, lo más probable es que la inmensa mayoría de los usuarios haga lo de siempre. Sacrificar privacidad por comodidad y hablar con la IA sin tapujos, contándole cosas mundanas y privadas por igual.

Y la IA lo guardará todo y lo sabrá todo.

Y quién sabe quién acabará usando esos datos, cómo y por qué.

No sé. Yo si fuera vosotros tendría cuidado con lo que le cuento a ChatGPT.

No vaya a ser que.

Bueno, esto será un paso más para confirmar las leyes 1 y 2 de Cipolla. Con X obtuvimos volumen y con esto veremos a los más avezados.

Respecto al tema jurídico, dependerá del sistema legal de cada país. Aquí en España dará igual lo que busques*. Si hubiera una preocupación real, el Barcelona estaría en segunda y medio gobierno en la cárcel.

*Salvo si es evadir impuestos. Si buscas como envenenar a alguien o hacer una bomba sucia da igual. Pero evadir impuestos es pecado capital. Los youtubers bien lo saben.

Una alternativa es que algunas IA acaben entrenándose con el material que solo los suficientemente incautos, idiotas o malintencionados le suministren. Y tal vez acaben siendo el mismo pozo de m… en que algunas redes sociales se han convertido. Como en todo, tendremos la IA de pobres y la de ricos.

La clave está en la COMODIDAD. Google abrió el melón y desde entonces la comodidad va por delante de nuestra privacidad en el orden de prioridades de la sociedad.

Yo por eso, aunque pueda no ser tan cómodo. uso duckduckgo en vez de google y duch.ai en vez cualquier otro chat de IA (valdría cualquier otro chat anónimo).

Y hacerlo en una ventana privada ya se ha convertido en una costumbre.

¿Habéis visto la entrevista a Durov?

https://www.youtube.com/watch?v=bxFQvOyTolg

Saludo

Pingback: Montarme mi propio ChatGPT cuesta 12.000 euros | Incognitosis

Guardar cualquier cosa en texto plano en un dispositivo conectado a internet…

Es obvio que no se nos enseña ni un mínimo de precauciones en ciberseguridad a la población, pero que ya prácticamente se nota que esta dejadez es totalmente interesada.

Luego ves a un chaval con su móvil petado de aplicaciones con Meta AI, los background services de Facebook, y Google culebreando por todo el OS y sus services….

Y te das cuenta porque muchos informáticos de redes y sistemas van con algún telefonillo que sólo hace llamadas.

Nos hemos habituado a interaccionar con máquinas que son verdaderas «cajas negras» para los profanos, vidas enteras «grabadas».

Habría que pensar si esto es reversible, o si simplemente, es realmente necesario.